NVIDIA InfiniBand Produkte

InfiniBand Switche

Auf der Suche nach den richtigen InfiniBand Switch? Hier finden Sie die passenden IB Modelle für jede AnforderungInfiniBand Adapter

Wir bieten Ihnen hier die passenden IB Netwerkadapter bis zu 400 Gb/sKabel, Module & Transceiver

Für passende IB und GbE Kabel, Module oder Transceiver besuchen Sie bitte unsere Unterseite.Sie benötigen eine Gigabit Ethernet Lösungen? Dann schauen Sie sich unsere Auswahl von Nvidia GbE Switchen und Adaptern an.

InfiniBand Switch Systeme

Die NVIDIA InfiniBand-Switch-Familie bietet höchste Leistung und Portdichte mit einer kompletten Fabric-Management-Lösung, mit denen Rechen-Cluster und konvergente Rechenzentren in jeder Größenordnung betrieben werden können. Gleichzeitig werden die Betriebskosten und die Komplexität der Infrastruktur gesenkt. Die Nvidia-Switche umfassen ein breites Portfolio an Edge- und Director-Switchen, die Portgeschwindigkeiten von bis zu 800 Gbit/s unterstützen und von 8 bis 800 Ports reichen.

Quantum-X800 Switche

NVIDIA Quantum-X800 InfiniBand-Switches bieten einen Durchsatz von 800 Gigabit pro Sekunde (Gb/s), extrem niedrige Latenzzeiten, fortschrittliches NVIDIA In-Network Computing und Funktionen, die die Gesamtanwendungsleistung in Hochleistungsrechenzentren (HPC) und KI-Rechenzentren steigern.

NEU! NEU! |  |  |  |  |

|---|---|---|---|---|

| Quantum-X800 | Q3200-RA | Q3400-RA | Q3401-RD | Q3450-LD |

| Rack mount | 2U | 4U | 4U | 4U |

| Ports | 36 | 144 | 144 | 144 |

| Speed | 800Gb/s | 800Gb/s | 800Gb/s | 800Gb/s |

| Performance | Two switches each of 28.8Tb/s throughput | 115.2Tb/s throughput | 115.2Tb/s throughput | 115.2Tb/s throughput |

| Switch radix | Two switches of 36 800Gb/s non-blocking ports | 144 800Gb/s non-blocking ports | 144 800Gb/s non-blocking ports | 144 800Gb/s non-blocking ports |

| Connectors and cabling | Two groups of 18 OSFP connectors | 72 OSFP connectors | 72 OSFP connectors | 144 MPO connectors |

| Management ports | Separate OSFP 400Gb/s InfiniBand in-band management port (UFM) | Separate OSFP 400Gb/s InfiniBand in-band management port (UFM) | Separate OSFP 400Gb/s InfiniBand in-band management port (UFM) | Separate OSFP 400Gb/s InfiniBand in-band management port (UFM) |

| Connectivity | Pluggable | Pluggable | Pluggable | MPO12 (Optics-only) |

| CPU | Intel CFL 4 Cores i3-8100H 3GHz | Intel CFL 4 Cores i3-8100H 3GHz | Intel CFL 4 Cores i3-8100H 3GHz | Intel CFL 4 cores i3-8100H 3GHz |

| Security | CPU/CPLD/Switch IC based on IRoT | CPU/CPLD/Switch IC based on IRoT | CPLD/Switch IC based on IRoT | CPU/CPLD/Switch IC based on IRoT |

| Software | NVOS | NVOS | NVOS | NVOS |

| Cooling mechanism | Air cooled | Air cooled | Air cooled | >Liquid cooled (85%) >Air cooled (15%) |

| EMC (emissions) | CE, FCC, VCCI, ICES, and RCM | CE, FCC, VCCI, ICES, and RCM | CE, FCC, VCCI, ICES, and RCM | CE, FCC, VCCI, ICES, and RCM |

| Product safety compliant/certified | RoHS, CB, cTUVus, CE, and CU | RoHS, CB, cTUVus, CE, and CU | RoHS, CB, cTUVus, CE, and CU | RoHS, CB, cTUVus, CE, and CU |

| Power Feed | 200-240V AC | 200-240V AC | 48-54V DC | 48V DC |

| Warranty | One year | One year | One year | One year |

Edge Switche

Die Edge Switch-Systeme bieten die leistungsstärksten Fabric-Lösungen in einem 1HE-Formfaktor, da diese eine Bandbreite von bis zu 51Tb/s mit der geringsten Port-zu-Port-Latenz liefern. Diese Edge-Switche eignen sich ideal für die Anbindung von Top-of-Rack-Systemen oder zum Aufbau kleiner bis mittelgroßer Cluster. Die Edge-Switche, die als extern gemanagte oder als direkt gemanagte Switche angeboten werden, wurden entwickelt um die effizientesten Switch-Fabrics mithilfe fortschrittlicher InfiniBand-Switching-Technologien wie Adaptive Routing, Congestion Control und Quality of Service zu erstellen.

|  |  |

|---|---|---|

| NVIDIA SWITCH-IB 2 SERIE | MSB7880 | MSB7890 |

| Typ | Router | Switch |

| SHARP | SHARP v1 | SHARP v1 |

| Ports | 36 | 36 |

| Höhe | 1HE | 1HE |

| Switching Kapazität | 7.2Tb/s | 7.2Tb/s |

| Verbindungsgeschwindigkeit | 100Gb/s | 100Gb/s |

| Interface Typ | QSFP28 | QSFP28 |

| Management | Ja (intern) | Nein (nur extern) |

| Management Ports | 1x RJ45, 1x RS232, 1x USB | 1x RJ45 |

| Power | 1+1 redundant and hot-swappable, 80 Gold+ and ENERGY STAR certified | |

| System Speicher | 4GB RAM DDR3 | |

| Storage | 16GB SSD | |

| Kühlung | Front-to-rear oder rear-to-front (hot-swappable fan unit) | |

|  |  |  |  |

|---|---|---|---|---|

| NVIDIA QUANTUM SERIE | MQM8700 | MQM8790 | MQM9700 | MQM9790 |

| Serie | Quantum | Quantum | Quantum-2 | Quantum-2 |

| SHARP | SHARP v2 | SHARP v2 | SHARP v3 | SHARP v3 |

| Ports | 40 | 40 | 64 | 64 |

| Höhe | 1HE | 1HE | 1HE | 1HE |

| Switching Kapazität | 16Tb/s | 16Tb/s | 51.2Tb/s | 51.2Tb/s |

| Verbindungsgeschwindigkeit | 200Gb/s | 200Gb/s | 400Gb/s | 400Gb/s |

| Interface Typ | QSFP56 | QSFP56 | QSFP | QSFP |

| Management | Ja (intern) | Nein (nur extern) | Ja (intern) | Nein (nur extern) |

| Management Ports | 1x RJ45, 1x RS232, 1x micro USB | 1x USB3.0, 1x USB for I2C, 1x RJ45, 1x RJ45(UART) | ||

| Power | 1+1 redundant and hot-swappable, 80 Gold+ and ENERGY STAR certified | |||

| System Speicher | Single 8GB | Single 8GB DDR4 SO-DIMM | ||

| Storage | --- | M.2 SSD SATA 16GB 2242 FF | ||

| Kühlung | Front-to-rear oder rear-to-front (hot-swappable fan unit) | |||

Modular Switches

Die modularen Nvidia Director-Switches bieten die Switching-Lösung mit der höchsten Dichte und skalieren von 8,64 TB/s bis zu 320TB/s Bandbreite in einem einzigen Gehäuse mit niedriger Latenz und den höchsten Geschwindigkeiten pro Port von bis zu 200 GBit/s. Das intelligente Design bietet beispiellose Leistungsebenen und vereinfacht die Erstellung von Clustern, die auf Tausende von Knoten skaliert werden können. Die modularen Switches von InfiniBand bieten Director-Class Verfügbarkeit, die für unternehmenskritische Anwendungsumgebungen erforderlich ist. Die Leaf-, Spin-Blades, Managementmodule sowie die Netzteile und Lüftereinheiten sind Hot-Swap-fähig, um Ausfallzeiten zu vermeiden.

|  |  |  |  |

|---|---|---|---|---|

| managed 324 - 800 ports | CS7520 | CS7510 | CS7500 | CS8500 |

| Ports | 216 | 324 | 648 | 324 |

| Höhe | 12U | 16U | 28U | 29U |

| Switching Kapazität | 43.2Tb/s | 64.8Tb/s | 130Tb/s | 320Tb/s |

| Verbindungsgeschwindigkeit | 100Gb/s | 100Gb/s | 100Gb/s | 200Gb/s |

| Interface Typ | QSFP28 | QSFP28 | QSFP28 | QSFP28 |

| Management | 2048 nodes | 2048 nodes | 2048 nodes | 2048 nodes |

| Management HA | Ja | Ja | Ja | Ja |

| Consolen Kabel | Ja | Ja | Ja | Ja |

| Spine Module | 6 | 9 | 18 | 20 |

| Leaf Module (max.) | 6 | 9 | 18 | 20 |

| PSU Redundanz | Ja (N+N) | Ja (N+N) | Ja (N+N) | Yes (N+N) |

| Fan Redundanz | Ja | Ja | Ja | Wasser Kühlung |

Vorteile von Nvidia Switch Systemen

- Gebaut mit Nvidia InfiniScale® und SwitchX™ Switch-Silizium der 4. und 5 Generation

- Branchenführende Energieeffizienz, Dichte und Kosteneinsparung

- Sehr niedrige Latenz

- Echtzeit skalierbare Netzwerk-Telemetrie

- Skalierbarkeit und Subnetzisolierung mithilfe von InfiniBand-Routing- und InfiniBand-zu-Ethernet-Gateway-Funktionen

- Granulare QoS für Cluster-, LAN- und SAN-Datenverkehr

- Schnelle und einfache Einrichtung und Verwaltung

- Maximiert die Leistung durch Entfernen von fabric congestions

- Fabric Management für Cluster- und konvergierte I/O-Anwendungen

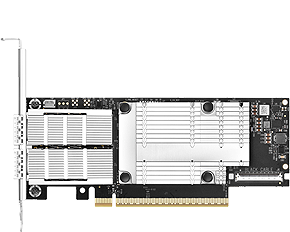

InfiniBand VPI Host-Channel Adapter

Nvidia ist weiterhin führend bei der Bereitstellung von InfiniBand Host Channel Adapters (HCA) - der leistungsfähigsten Interconnect-Lösung für Enterprise Data Center, Web 2.0, Cloud Computing, High Performance Computing und Embedded-Umgebungen.

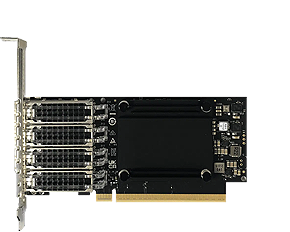

ConnectX-7 SmartNIC Adapter Karten

Mit bis zu vier Konnektivitätsports und einem Daten-Durchsatz von 400 Gbit/s bietet die NVIDIA ConnectX-7 SmartNIC hardwarebeschleunigte Netzwerk-, Speicher-, Sicherheits- und Verwaltungsdienste im Rechenzentrumsmaßstab für Cloud-, Telekommunikations-, KI- und Unternehmens-Workloads. ConnectX-7 ermöglicht agile und leistungsstarke Netzwerklösungen mit Funktionen wie Accelerated Switching and Packet Processing (ASAP2), erweitertem RoCE, GPUDirect Storage und Inline-Hardwarebeschleunigung für Transport Layer Security (TLS), IP Security (IPsec), und MAC Security (MACsec) Verschlüsselung und Entschlüsselung.

|  |  |  |  |  |  |

|---|---|---|---|---|---|---|

| ConnectX-7 | MCX75310AAS-HEAT | MCX75310AAS-NEAT | MCX753436MC-HEAB MCX753436MS-HEAB MCX755106AC-HEAT MCX755106AS-HEAT | MCX715105AS-WEAT | MCX755106AS-HEAT MCX755106AC-HEAT | MCX75310AAC-NEAT MCX75343AMC-NEAC MCX75343AMS-NEAC |

| ASIC & PCI Dev ID | ConnectX®-7 | |||||

| Speed | 200GbE / NDR200 | 400GbE / NDR | 200GbE / NDR200 | 400GbE / NDR | 200GbE / NDR200 | 400GbE / NDR |

| Technology | VPI*3 | VPI*2 | VPI | VPI | VPI | VPI |

| Ports | 1 | 1 | 2 | 1 | 2 | 1 |

| Connectors | QSFP | QSFP | QSFP112 | OSFP112 | OSFP112 | OSFP |

| PCIe | PCIe 5.0 x16 | PCIe 5.0 x16 | PCIe 5.0 x16 | PCIe 5.0 x16 | PCIe 5.0 x16 | PCIe 5.0 x16 |

| Secure Boot | ✔ | ✔ | ✔ | ✔ | ✔ | ✔ |

| Crypto | - | - | (✔)*1 | - | (✔)*1 | (✔)*1 |

| Form Factor | HHHL | HHHL | MCX753436: SFF MCX755106: HHHL | HHHL | HHHL | MCX75310: HHHL MCX75343: SFF |

|  |  |  |  |  |

|---|---|---|---|---|---|

| ConnectX-7 | MCX713104AC-ADAT MCX713104AS-ADAT | MCX713114TC-GEAT | MCX75510AAS-HEAT | MCX753436MC-HEAB MCX753436MS-HEAB | MCX75343AMC-NEAC MCX75343AMS-NEAC |

| ASIC & PCI Dev ID | ConnectX®-7 | ||||

| Speed | 50/25GbE | 50/25GbE | NDR200 | 200GbE / NDR200/HDR | 400GbE / NDR |

| Technology | Ethernet | Ethernet | IB | VPI | VPI |

| Ports | 4 | 4 | 1 | 2 | 1 |

| Connectors | SFP56 | SFP56 | OSFP | QSFP112 | OSFP |

| PCIe | PCIe 4.0 x16 | PCIe 4.0 x16 | PCIe 5.0 x16 | PCIe 5.0 x16 | PCIe 5.0 x16 |

| Secure Boot | ✔ | ✔ | ✔ | ✔ | ✔ |

| Crypto | (✔)*1 | ✔ | - | (✔)*1 | (✔)*1 |

| Form Factor | HHHL | FHHL | HHHL | SFF | TSFF |

HHHL (Tall Bracket) = 6.6" x 2.71" (167.65mm x 68.90mm); FHHL = 4.53" x 6.6" (115.15mm x 167.65mm); TSFF = Tall Small Form Factor; OCP 3.0 SSF (Thumbscrew Bracket) = 4.52" x 2.99" (115.00mm x 76.00mm)

*2The MCX75310AAS-NEAT card supports InfiniBand and Ethernet protocols from hardware version AA and higher.

*3The MCX75310AAS-HEAT card supports InfiniBand and Ethernet protocols from hardware version A7 and higher.

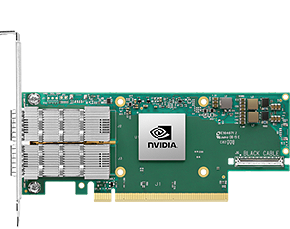

ConnectX-6 VPI Karten

ConnectX-6 mit Virtual Protocol Interconnect® (VPI) unterstützt zwei Ports mit 200Gbit/s InfiniBand- und Ethernet-Konnektivität. Die Karten erreichen Latenzzeiten von unter 600 Nanosekunden und 200 Millionen Nachrichten pro Sekunde und bietet die höchste Leistung und flexibelste für die anspruchsvollsten Anwendungsgebiete. Mit 200 Gbit/s (HDR) InfiniBand, 100 Gbit/s (HDR100) InfiniBand und 200Gbit/s Ethernet-Geschwindigkeiten bietet es einen der höchsten Datendurchsätze und Nachrichtenraten in der Branche. Es ist das perfekte Produkt, um HPC-Rechenzentren auf Exascale-Leistung und Skalierbarkeit auszurichten. Unterstützte Geschwindigkeiten sind HDR, HDR100, EDR, FDR, QDR, DDR und SDR InfiniBand sowie 200, 100, 50, 40, 25 und 10 Gb/s Ethernet. Alle Geschwindigkeiten der Karten sind abwärtskompatibel.

|  |  |  |

|---|---|---|---|

| ConnectX-6 | MCX653436A-HDAB*1 | MCX653105A-HDAT*1 | MCX653106A-HDAT*1 |

| ASIC & PCI Dev ID | ConnectX®-6 | ||

| Technology | VPI | VPI | VPI |

| Speed | HDR/200GbE | HDR/200GbE | HDR/200GbE |

| Ports | 2 | 1 | 2 |

| Connectors | QSFP56 | QSFP56 | QSFP56 |

| PCI | PCIe 4.0 | PCIe 4.0 | PCIe 4.0 |

| Lanes | x16 | x16 | x16 |

| Crypto | - | - | - |

| Form Factor | PCIe Standup. w/o Bracket: 167.65mm x 8.90mm. Tall bracket | ||

|  |  |  |

|---|---|---|---|

| ConnectX-6 | MCX651105A-EDAT | MCX653105A-ECAT | MCX653106A-ECAT |

| ASIC & PCI Dev ID | ConnectX®-6 | ||

| Technology | VPI | VPI | VPI |

| Speed | HDR100/EDR IB/100GbE | HDR100/EDR IB/100GbE | HDR100/EDR IB/100GbE |

| Ports | 1 | 1 | 2 |

| Connectors | QSFP56 | QSFP56 | QSFP56 |

| PCI | PCIe 4.0 | PCIe 3.0/4.0 | PCIe 3.0/4.0 |

| Lanes | x8 | x16 | x16 |

| Crypto | - | - | - |

| Form Factor | PCIe Standup. w/o Bracket: 167.65mm x 8.90mm. Tall bracket | ||

Die Stärken von Nvidia VPI Host-Channel-Adaptern

Die Vorteile

- Weltklasse Cluster Performance

- Leistungsfähiger Netzwerk- und Speicherzugriff

- Effiziente Nutzung von Rechenressourcen

- Modernste Performance in virtualisierten Overlay-Netzwerken (VXLAN und NVGRE)

- Erhöhte VM pro Server-Verhältnis

- Garantierte Bandbreite und Dienste mit niedriger Latenz

- Zuverlässiger Transport

- Effiziente I/O-Konsolidierung, Senkung der Rechenzentrumskosten und Komplexität

- Skalierbarkeit auf Zehntausende von Knoten

Ziel Anwendungen

- Hochleistungsfähige Parallelisierung

- Rechenzentrumsvirtualisierung

- Öffentliche und private Clouds

- Große Web 2.0 und Datenanalyse-Anwendungen

- Clustered-Datenbank-Anwendungen, parallele RDBMS-Abfragen, Data Warehousing mit hohem Durchsatz

- Latenz-sensitive Anwendungen wie Finanzanalyse und Handel

- Performancelastige Speicheranwendungen wie Backup, Restore, Mirroring usw.

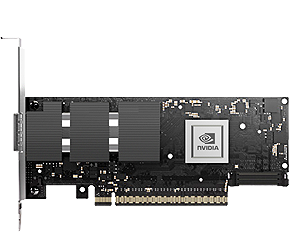

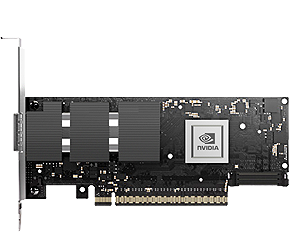

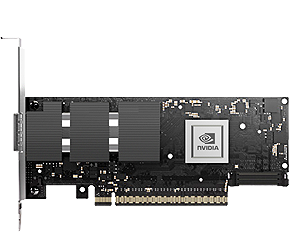

NVIDIA DPU (Data Processing Unit)

Die NVIDIA® BlueField®-Datenverarbeitungseinheit (DPU) ist praktisch ein System auf einen Chip, ein Hardwarebeschleuniger spezialisiert für komplexe aufgaben wie schnelle Datenverarbeitung und das datenzentrierte Rechnen. Diese soll in erster Linie die CPU von Netzwerk- und Kommunikationsaufgaben entlasten und damit CPU Resourecen einsparen, in dem es selbst anwendungsunterstützende Aufgaben wie Datentransfer, Datenreduzierung, Datensicherheit und Analysen auslagert und übernimmt. Der Einsatz sollch einer DPU eignet sich besonders für alle Workloads mit Supercomputing-Aufgaben wie KI, Cloud und Big Data. Ein igenes dediziertes Betriebssystem auf dem Chip lässt sich mit dem primären Betriebssystems kombinieren und bittet Funktionen wie Verschlüsselung, Erasure Coding sowie Komprimierung oder Dekomprimierung.

|  |  |  |  |  |

|---|---|---|---|---|---|

| BlueField®-2 IB DPUs | MBF2M345A | MBF2H516A | MBF2H516C | MBF2M516A | MBF2M516C |

| Serie / Core Speed | E-Series / 2.0GHz | P-Series / 2.75GHz | E-Series / 2.0GHz | ||

| Form Factor | Half-Height Half-Length (HHHL) | Full-Height Half-Length (FHHL) | |||

| Ports | 1x QSFP56 | 2x QSFP56 | 2x QSFP56 | 2x QSFP56 | 2x QSFP56 |

| Speed | 200GbE / HDR | 100GbE / EDR / HDR100 | |||

| PCI | PCIe 4.0 x16 | ||||

| On-board DDR | 16GB | ||||

| On-board eMMC | 64GB | 64GB | 128GB | 64GB | 128GB |

| Secure Boot | ✓ | - | ✓ | ✓ (*1) | ✓ |

| Crypto | ✓ (*1) | ✓ (*1) | ✓ (*1) | ✓ (*1) | ✓ (*1) |

| 1GbE OOB | ✓ | ✓ | ✓ | ✓ | ✓ |

| Integrierte BMC | - | - | ✓ | ✓ | ✓ |

| Externe Leistung | - | ✓ | ✓ | - | - |

| PPS IN/OUT | - | - | - | ✓ | ✓ |

| BlueField® IB DPUs (erste Gen.) | ||

|---|---|---|

| Model Name | Beschreibung | Crypto |

| MBF1L516A-ESCAT | BlueField® DPU VPI EDR IB (100Gb/s) und 100GbE, Dual-Port QSFP28, PCIe Gen4.0 x16, BlueField® G-Series 16 cores, 16GB on-board DDR, FHHL, Single Slot, Tall Bracket | ✓ |

| MBF1L516A-ESNAT | BlueField® DPU VPI EDR IB (100Gb/s) und 100GbE, Dual-Port QSFP28, PCIe Gen4.0 x16, BlueField® G-Series 16 cores, 16GB on-board DDR, FHHL, Single Slot, Tall Bracket | - |